γράφει ο Νικόλαος Κατσουλώτης*

Η τεχνητή νοημοσύνη είναι ένα εργαλείο. Χρήσιμο ή επικίνδυνο, αυτό εξαρτάται από τον τρόπο με τον οποίο το χρησιμοποιεί ο καθένας. Η ίδια τεχνητή νοημοσύνη που συμβάλλει στη δημιουργία και διάδοση ψευδών ειδήσεων, είναι η ίδια που συνεισφέρει στην επιστημονική έρευνα και η ίδια που απλουστεύει καθημερινά τη ζωή μας. Το μόνο που χρειάζεται, είναι να είμαστε όλοι λίγο πιο καχύποπτοι και να ελέγχουμε προσεκτικά τις πηγές μας.

Ο Max Headroom «γεννήθηκε» στις 4 Απριλίου 1985 από τον συγγραφέα George Stone και τους σκηνοθέτες Annabel Jankel και Rocky Morton. Δεν πρόκειται φυσικά για άνθρωπο, αλλά για τον πρώτο «κατασκευασμένο» παρουσιαστή τηλεοπτικού προγράμματος που απέκτησε παγκόσμια αναγνώριση. Την τηλεοπτική αυτή περσόνα κλήθηκε να υποδυθεί ο ηθοποιός Matt Frewer, ο οποίος, για να μεταμορφωθεί σε Max Headroom, έπρεπε να φορά λάτεξ μαλλιά, έντονο προσθετικό μακιγιάζ από αφρό και κοστούμι από fiberglass.

Η μορφή και το ύφος ομιλίας του παρέπεμπαν, με σατιρικό τρόπο, στην εγωιστική και αδιάφορη προσωπικότητα των τηλεπαρουσιαστών στη δεκαετία του 1980. Είναι όμως και η πρώτη ίσως προσπάθεια απεικόνισης της τεχνητής νοημοσύνης, έτσι όπως τη φαντάζονταν την εποχή εκείνη· με τη μορφή δηλαδή ενός ανδρείκελου ρεπόρτερ που έχει άδειο βλέμμα και ομιλεί με μηχανική φωνή.

Η μετάδοση πληροφορίας ανέκαθεν απαιτούσε τη συμβολή ανθρώπινου και μηχανικού παράγοντα. Αυτή η μείξη έχει ως αποτέλεσμα τη δημιουργία μέσων που αποκαλούνται συνθετικά. Ωστόσο, κάτι έχει αλλάξει από την εποχή του Max Headroom μέχρι σήμερα.

Στην περίπτωση εκείνη, 35 χρόνια πριν, η συμβολή της τεχνολογίας περιοριζόταν στην ηλεκτρονική αλλοίωση της φωνής του παρουσιαστή, και στα κινούμενα ποπ σχέδια που αναπαράγονταν πίσω από αυτόν. Από τότε, νέες μηχανικές και τεχνολογικές συσκευές εισέβαλαν και συνέβαλαν στη μετάδοση πληροφοριών, όπως ο ηλεκτρονικός υπολογιστής, τα autocue, τα green/blue screens κ.ά.

Σήμερα, εξαιτίας της εξάπλωσης και διάδοσης της τεχνητής νοημοσύνης (Artificial Inteligence) στον χώρο των ΜΜΕ, ο ανθρώπινος παράγοντας εκλίπει ολοένα και περισσότερο από την παραγωγική διαδικασία των ειδήσεων.

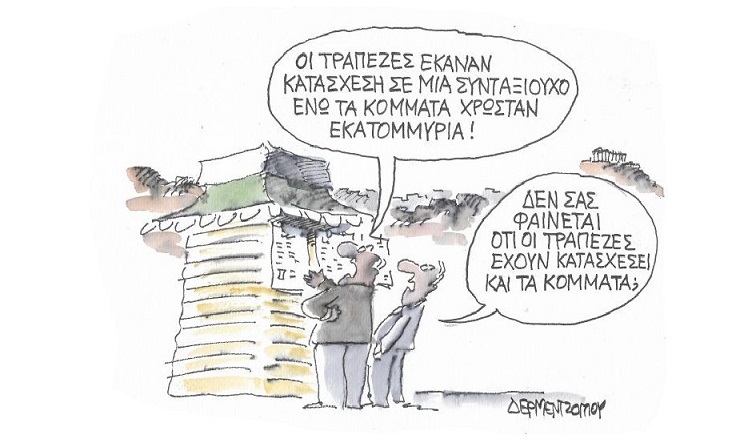

Και μπορεί ο λόγος της έντονης συμβολής της τεχνολογίας (εν προκειμένω της AI) στην παραγωγή πληροφοριακού υλικού, να προσφέρει ειδήσεις με μεγαλύτερο ενδιαφέρον και ευληπτότητα στο εκάστοτε αναγνωστικό και τηλεοπτικό κοινό, ωστόσο, όταν η τεχνητή νοημοσύνη λειτουργεί ανεξέλεγκτα και χωρίς περιορισμούς, παρουσιάζονται έντονα φαινόμενα παραπληροφόρησης και ψευδών ειδήσεων.

Αυτό το φαινόμενο προσπαθούν με κάθε δυνατό τρόπο να εξαλείψουν τα μεγαλύτερα social media από τις πλατφόρμες τους. Από τον Δεκέμβριο του 2016, και μετά την αναταραχή που προκλήθηκε με την ανάμειξη της ρωσικής κυβέρνησης στις προεδρικές εκλογές των Ηνωμένων Πολιτειών της Αμερικής, το Facebook σε συνεργασία με 50 και πλέον ανεξάρτητους οργανισμούς διερεύνησης ψευδών ειδήσεων (fact-checkers), προσπαθεί να καταπολεμήσει –ή έστω να μειώσει– το πρόβλημα της παραπληροφόρησης.

Μια άλλη μέθοδος που ακολουθείται είναι ο αποκλεισμός αναξιόπιστων άρθρων (βλ. χωρίς αναγραφόμενη πηγή) με βάση το λεξιλόγιο που χρησιμοποιούν. Είναι αποδεδειγμένο πως, στην πλειονότητά τους, τα δόλια κείμενα που παραποιούν την αλήθεια εμπεριέχουν εμπρηστικές και πομπώδεις (εκ)φράσεις, εν μέρει επειδή ο σκοπός τους είναι να αναζητούν δημοσιότητα και κλικ.[1]

Με τη βοήθεια μοντέλων machine learning, όπως τα n-grams (πρόβλεψη λεξιλογίου σύμφωνα με την πρόταση που προηγήθηκε) και bag of words (συλλογή και ταξινόμηση επαναλαμβανόμενων λέξεων εντός του κειμένου), είναι δυνατόν να προσδιοριστεί η αυθεντικότητα και αξιοπιστία ενός δημοσιογραφικού άρθρου.

Τον ίδιο δρόμο ακολούθησε το Instagram, το οποίο επιτρέπει πλέον στους χρήστες να καταγγείλουν δυνητικά ψευδείς δημοσιεύσεις, επιλέγοντας «αναφορά» (report) και στην συνέχεια «είναι ανεπιθύμητο» (spam) ή «είναι ακατάλληλο» (inappropriate). Το Twitter με τη σειρά του, δημοσίευσε πρόσφατα τη νέα του πολιτική, σύμφωνα με την οποία θα επισημαίνει εικόνες ή/και βίντεο που ενδέχεται να έχουν υποστεί ψηφιακή επεξεργασία με τρόπο που αλλοιώνουν την πραγματικότητα.[2]

Ολα αυτά αφορούν τα ίδια τα media και τα εργαλεία που έχουν στη διάθεσή τους να ταυτοποιήσουν τις ειδήσεις και τις πληροφορίες που προβάλλουν. Τι γίνεται όμως για τους απλούς χρήστες;

Εντονη είναι τα τελευταία χρόνια η ανάδυση και εμφάνιση προγραμμάτων και εφαρμογών που δίνουν τη δυνατότητα ακόμη και σε αρχάριους χρήστες, να δημιουργήσουν τα δικά τους βίντεο και φωτογραφίες, με έναν τρόπο που αν και εκ πρώτης όψεως μοιάζει διασκεδαστικός, εντούτοις κρύβει έναν πολύ μεγάλο και σοβαρό κίνδυνο· την εξάπλωση οπτικο-ακουστικών μέσων τόσο αληθοφανών, που, ακόμη και ένα έμπειρο μάτι, ύστερα από ενδελεχή έλεγχο, να δυσκολεύεται να διακρίνει τι είναι πραγματικό και τι όχι.

Ο κίνδυνος είναι ακόμη μεγαλύτερος σε κοινωνικο-πολιτικό πλαίσιο, εάν αναλογιστεί κανείς ότι η παραπληροφόρηση δεν λειτουργεί μόνο προς μία κατεύθυνση. Οσο τα τεχνολογικά μέσα προοδεύουν και τα όρια μεταξύ πραγματικού και «φανταστικού» θολώνουν, καλλιεργείται η δυσπιστία και η στρέβλωση των κοινωνικών αξιών.

Τι θα συμβεί, με άλλα λόγια, εάν πραγματικά δεδομένα αρχίζουν να παρουσιάζονται ως παραποιημένες πληροφορίες; Το τελευταίο έχει ήδη αρχίσει να συμβαίνει, καθώς εκλεγμένοι ηγέτες από όλο τον κόσμο χρησιμοποιούν τη φράση «fake news», για οτιδήποτε δεν συμφωνούν, σαν…καραμέλα.

Και το ζήτημα δεν σταματά μονάχα στη μετάδοση πληροφοριών. Εδώ και πέντε περίπου χρόνια, ένας άλλος νέος όρος μπήκε στη ζωή μας, το deepfake, την πιο ξεχωριστή –και πιο επικίνδυνη– υποκατηγορία των συνθετικών μέσων. Σε αυτά τα μέσα, τα χαρακτηριστικά προσώπου ενός ανθρώπου αντικαθίστανται με ενός άλλου, με τη βοήθεια πανίσχυρων εργαλείων όπως το machine learning και η τεχνητή νοημοσύνη. Τι μπορεί να πετύχει κανείς με λίγα λόγια; Για παράδειγμα, να «βάλει» στην κυριολεξία λόγια στο στόμα του προέδρου των Ηνωμένων Πολιτειών της Αμερικής![3]

Η μέθοδος της ψηφιακής τροποποίησης ενός προσώπου ώστε να ομιλεί όπως ακριβώς εμείς επιθυμούμε, δεν είναι καινούρια. Το Πανεπιστήμιο Stanford έχει δημοσιεύσει ήδη από το 2016 την έρευνά του με θέμα το πρόγραμμα Face2Face.[4]

Μια άλλη παρόμοια εφαρμογή –που μάλιστα έγινε viral στην Κίνα– ήταν το Zao, όπου ο καθένας μπορούσε να τοποθετήσει το πρόσωπό του σε διάσημες σκηνές από χολιγουντιανές ταινίες. Και τα προγράμματα δεν σταματούν εδώ… Ενδεικτικά αναφέρονται τα εξής: DeepFace Lab, Faceswap (δωρεάν και ανοιχτού κώδικα), Deepfakes web β, Doublicat, Morphin, Face Swap Booth.

Στο ίδιο μοτίβο, online εταιρείες λογισμικών όπως οι Icons8 και Rosebud AI προ(σ)καλούν τους χρήστες, να αλλάζουν τα χαρακτηριστικά των μοντέλων σε φωτογραφίες, σύμφωνα με τις ανάγκες τους και τη γεωγραφική τους θέση, με το πάτημα ενός κουμπιού! Από την άλλη μεριά, εμφάνιση αντίστοιχων εταιρειών όπως οι Deeptrace και Truepic, οι οποίες καλούνται να τεκμηριώσουν την αυθεντικότητα εικόνων και βίντεο που κατακλύζουν το διαδίκτυο, αποδεικνύει ότι βρισκόμαστε σε έναν πόλεμο μεταξύ αλήθειας και ψέματος.

Ο λόγος που γράφεται αυτό το άρθρο δεν είναι για να αφορίσω την τεχνολογική ανάπτυξη. Διότι η τεχνητή νοημοσύνη είναι ένα εργαλείο. Χρήσιμο ή επικίνδυνο, αυτό εξαρτάται από τον τρόπο με τον οποίο το χρησιμοποιεί ο καθένας. Η ίδια τεχνητή νοημοσύνη που συμβάλλει στη δημιουργία και διάδοση ψευδών ειδήσεων, είναι η ίδια που συνεισφέρει στην επιστημονική έρευνα και η ίδια που απλουστεύει καθημερινά τη ζωή μας. Το μόνο που χρειάζεται, είναι να είμαστε όλοι λίγο πιο καχύποπτοι για το τι περνά μπροστά από τα μάτια μας και, κυρίως, να ελέγχουμε πιο εντατικά και προσεκτικά τις πηγές της ενημέρωσής μας.

1. Liu, Huan; Tang, Jiliang; Wang, Suhang; Sliva, Amy; Shu, Kai (7 August 2017). «Fake News Detection on Social Media: A Data Mining Perspective».

2.https://blog.twitter.com

3. youtube.com/watch

4. Thies, Justus; Zollhöfer, Michael; Stamminger, Marc; Theobalt, Christian; Nießner, Matthias; (2016). «Face2Face: Real-time Face Capture and Reenactment of RGB Videos», Proc. Computer Vision and Pattern Recognition (CVPR) IEEE.

* δρ Ψηφιακών Μέσων

πηγή: efsyn

e-prologos.gr